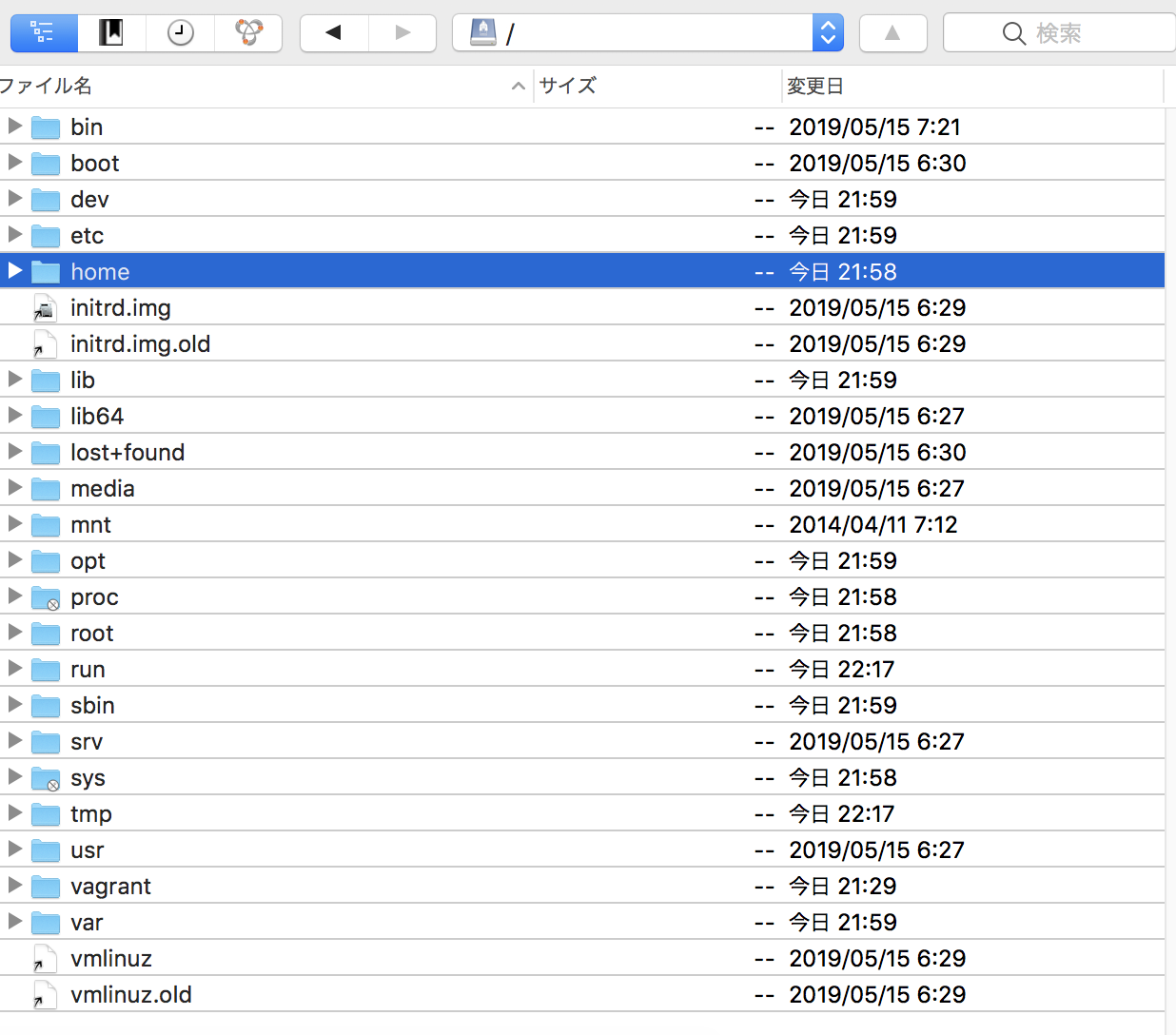

ubuntuにgo言語実装のgo-ethereumを入れる

vagrant@vagrant-ubuntu-trusty-64:~$ mkdir ethereum

vagrant@vagrant-ubuntu-trusty-64:~$ ls

ethereum

vagrant@vagrant-ubuntu-trusty-64:~$ cd ethereum

vagrant@vagrant-ubuntu-trusty-64:~/ethereum$ sudo apt-get install -y build-essential libgmp3-dev golang

vagrant@vagrant-ubuntu-trusty-64:~/ethereum$ sudo apt-get install git

vagrant@vagrant-ubuntu-trusty-64:~/ethereum$ git version

git version 1.9.1

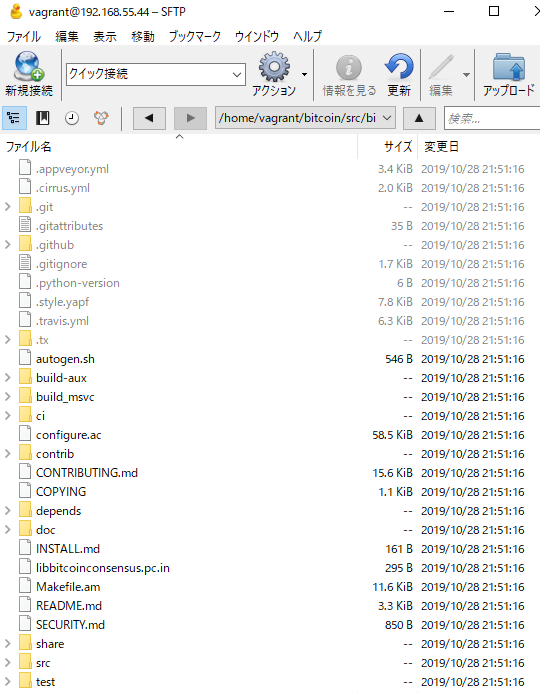

vagrant@vagrant-ubuntu-trusty-64:~/ethereum$ git clone -b release/1.3.6 https://github.com/ethereum/go-ethereum.git

おおお

vagrant@vagrant-ubuntu-trusty-64:~/ethereum$ make -C go-ethereum geth

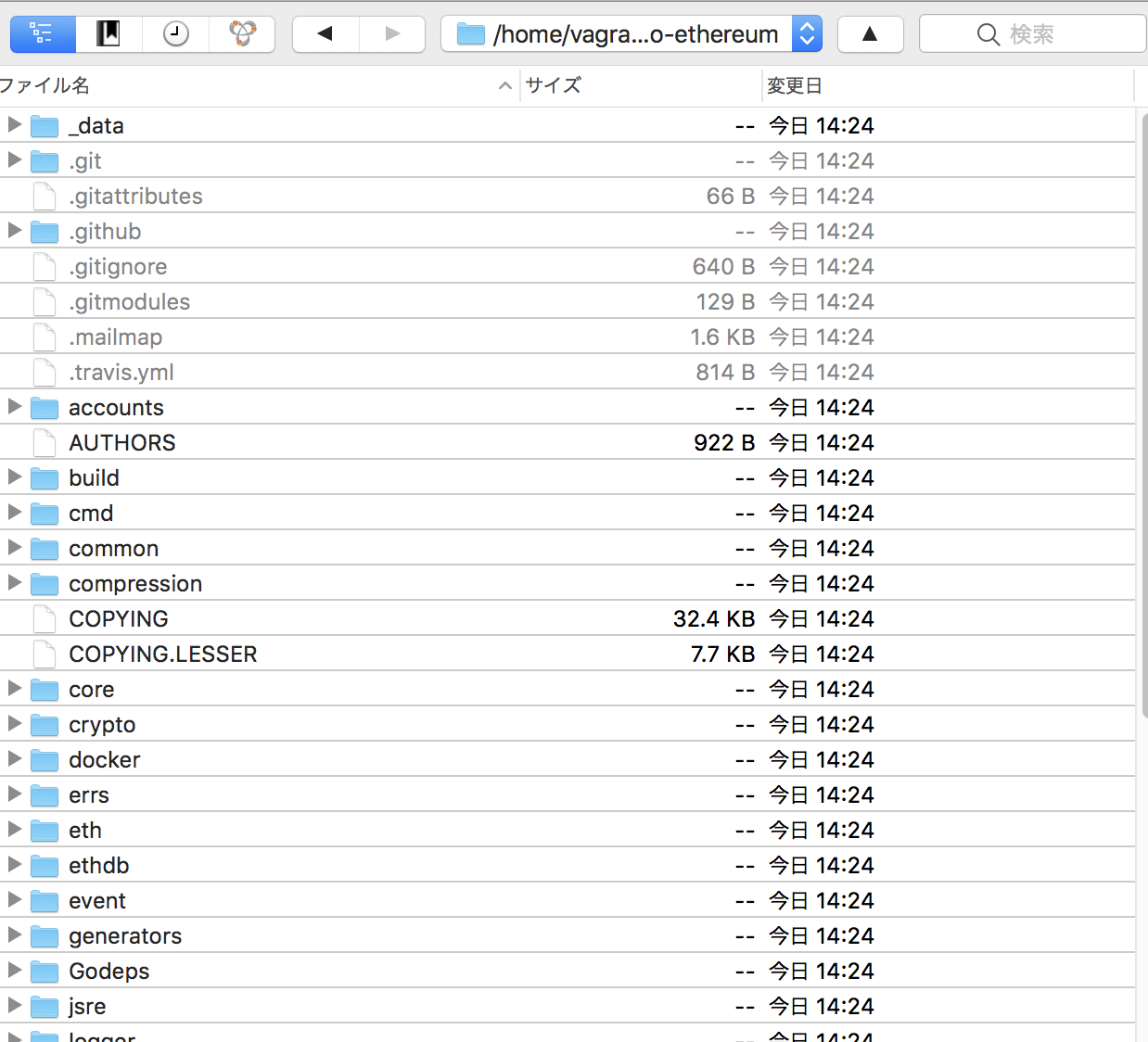

make: Entering directory `/home/vagrant/ethereum/go-ethereum’

build/env.sh go install -v -ldflags ‘-X main.gitCommit bf324bd24be9036046e36c6248b2d7c31cce9eca’ ./cmd/geth

github.com/codegangsta/cli

github.com/ethereum/go-ethereum/rlp

# github.com/ethereum/go-ethereum/rlp

build/_workspace/src/github.com/ethereum/go-ethereum/rlp/encode.go:162: undefined: sync.Pool

github.com/ethereum/go-ethereum/crypto/ecies

github.com/ethereum/go-ethereum/crypto/sha3

github.com/ethereum/go-ethereum/crypto/randentropy

github.com/ethereum/go-ethereum/crypto/secp256k1

github.com/pborman/uuid

golang.org/x/crypto/pbkdf2

golang.org/x/crypto/ripemd160

golang.org/x/crypto/scrypt

github.com/ethereum/go-ethereum/logger/glog

github.com/ethereum/go-ethereum/params

github.com/hashicorp/golang-lru

github.com/rcrowley/go-metrics

github.com/syndtr/goleveldb/leveldb/util

github.com/syndtr/goleveldb/leveldb/cache

github.com/syndtr/goleveldb/leveldb/comparer

github.com/syndtr/goleveldb/leveldb/storage

github.com/syndtr/goleveldb/leveldb/errors

github.com/syndtr/goleveldb/leveldb/filter

github.com/syndtr/goleveldb/leveldb/iterator

github.com/syndtr/goleveldb/leveldb/journal

github.com/syndtr/goleveldb/leveldb/memdb

github.com/syndtr/goleveldb/leveldb/opt

github.com/syndtr/gosnappy/snappy

github.com/syndtr/goleveldb/leveldb/table

github.com/syndtr/goleveldb/leveldb

gopkg.in/karalabe/cookiejar.v2/collections/prque

github.com/ethereum/go-ethereum/event

gopkg.in/fatih/set.v0

github.com/huin/goupnp/httpu

github.com/huin/goupnp/scpd

github.com/huin/goupnp/soap

github.com/huin/goupnp/ssdp

golang.org/x/net/html/atom

golang.org/x/net/html

golang.org/x/text/transform

golang.org/x/text/encoding

golang.org/x/text/encoding/internal/identifier

golang.org/x/text/encoding/internal

golang.org/x/text/encoding/charmap

golang.org/x/text/encoding/japanese

golang.org/x/text/encoding/korean

golang.org/x/text/encoding/simplifiedchinese

golang.org/x/text/encoding/traditionalchinese

golang.org/x/text/encoding/unicode

golang.org/x/net/html/charset

github.com/huin/goupnp

# github.com/huin/goupnp

build/_workspace/src/github.com/ethereum/go-ethereum/Godeps/_workspace/src/github.com/huin/goupnp/goupnp.go:113: unknown http.Client field ‘Timeout’ in struct literal

github.com/jackpal/go-nat-pmp

github.com/ethereum/go-ethereum/event/filter

github.com/robertkrimen/otto/file

github.com/robertkrimen/otto/token

github.com/robertkrimen/otto/ast

github.com/robertkrimen/otto/dbg

github.com/robertkrimen/otto/parser

github.com/robertkrimen/otto/registry

github.com/robertkrimen/otto

github.com/rs/cors

github.com/peterh/liner

github.com/mattn/go-isatty

github.com/shiena/ansicolor

github.com/fatih/color

github.com/mattn/go-runewidth

github.com/nsf/termbox-go

github.com/gizak/termui

make: *** [geth] Error 2

make: Leaving directory `/home/vagrant/ethereum/go-ethereum’

vagrant@vagrant-ubuntu-trusty-64:~/ethereum$ go version

go version go1.2.1 linux/amd64

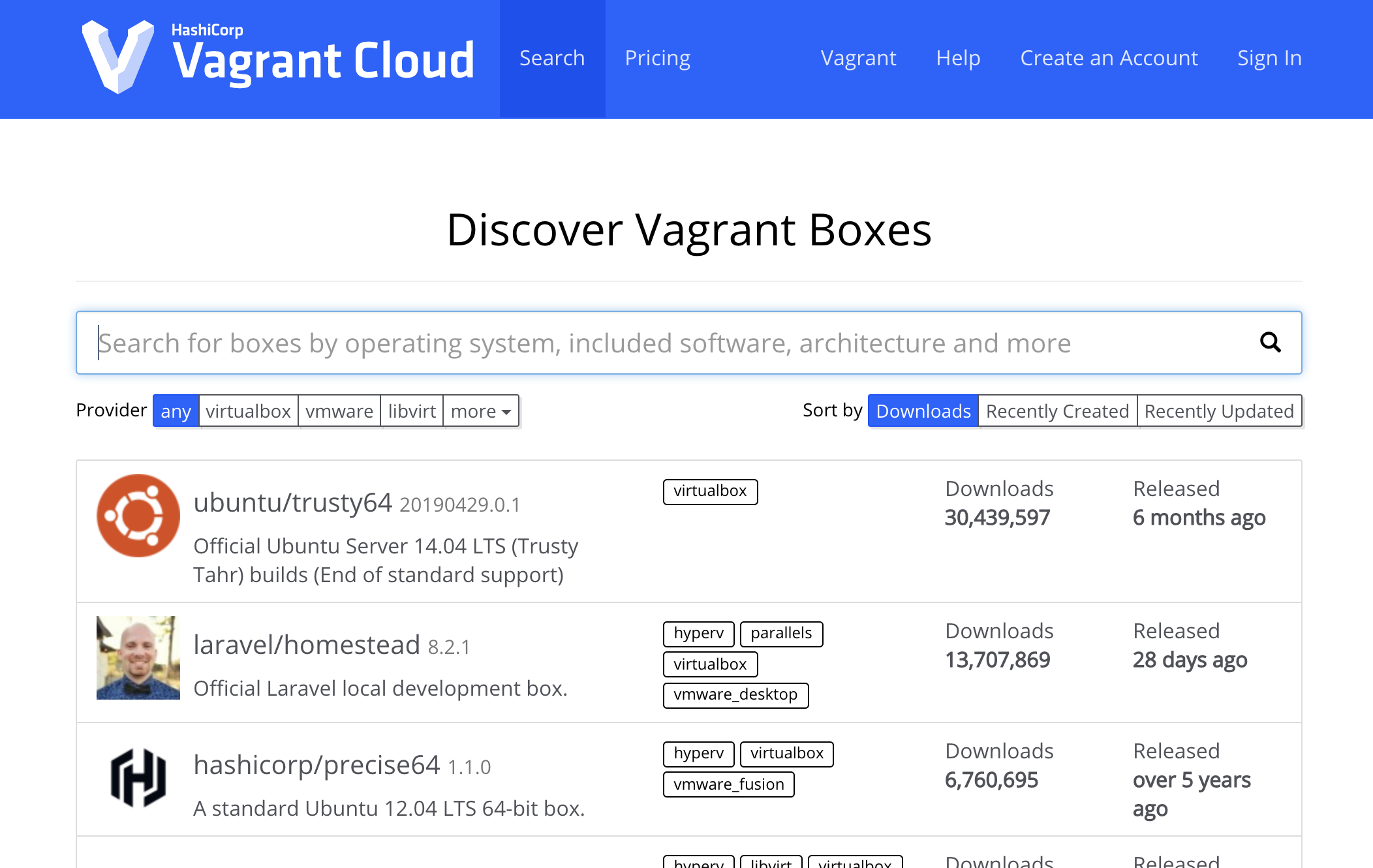

https://github.com/ethereum/go-ethereum

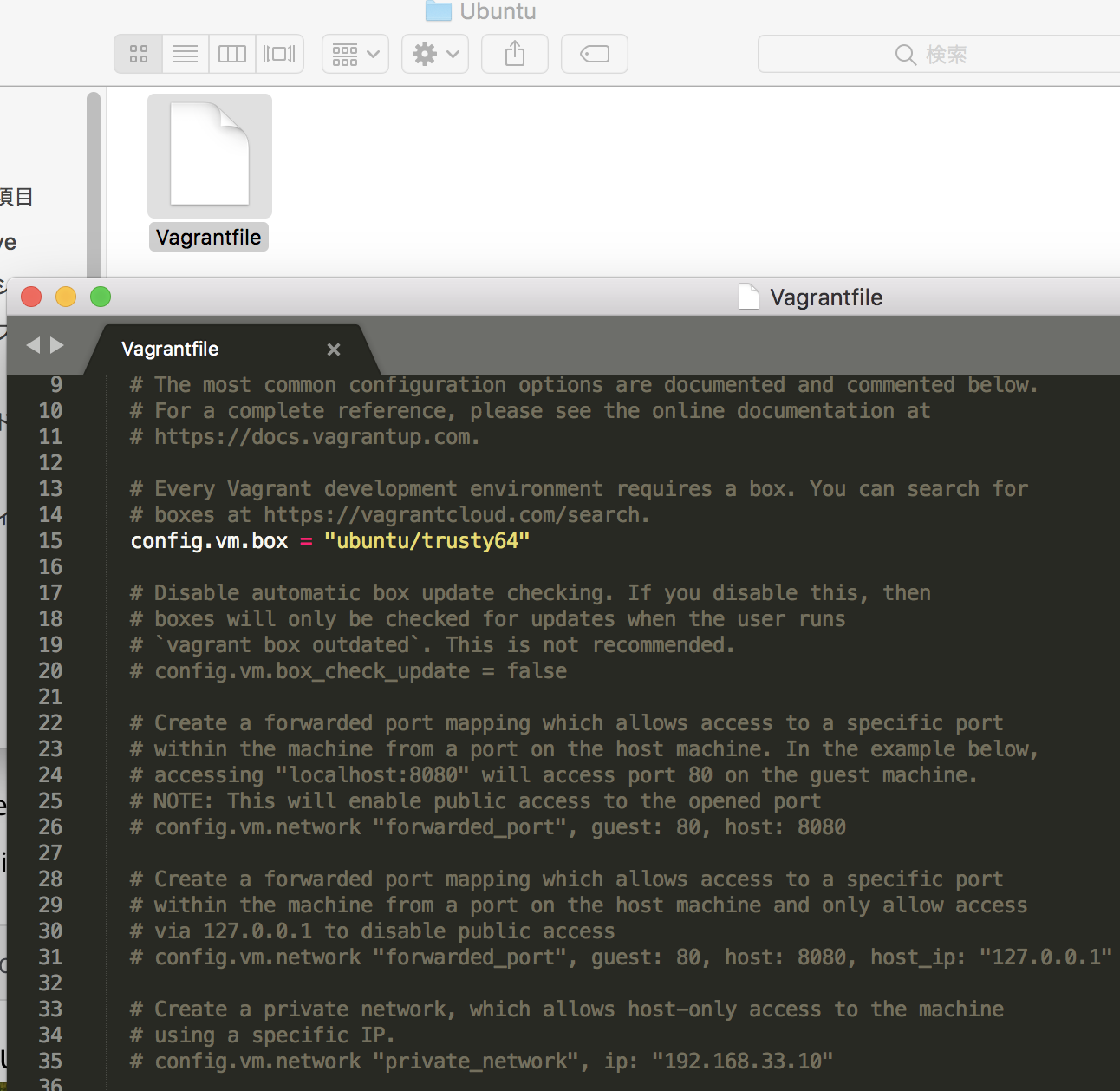

Building geth requires both a Go (version 1.10 or later) and a C compiler. You can install them using your favourite package manager. Once the dependencies are installed, run

あれ?