vue-cliの中身を見ていきましょう

index.html

<!DOCTYPE html>

<html>

<head>

<meta charset="utf-8">

<meta name="viewport" content="width=device-width,initial-scale=1.0">

<title>test</title>

</head>

<body>

<div id="app"></div>

<!-- built files will be auto injected -->

</body>

</html>

main.js

import Vue from 'vue'

import App from './App'

import router from './router'

Vue.config.productionTip = false

/* eslint-disable no-new */

new Vue({

el: '#app',

router,

components: { App },

template: '<App/>'

})

あああああああ、react+webpackと同じような仕組みですね。

ん? これはviewの部分か?

App.vue

<template>

<div id="app">

<img src="./assets/logo.png">

<router-view/>

</div>

</template>

<script>

export default {

name: 'App'

}

</script>

<style>

#app {

font-family: 'Avenir', Helvetica, Arial, sans-serif;

-webkit-font-smoothing: antialiased;

-moz-osx-font-smoothing: grayscale;

text-align: center;

color: #2c3e50;

margin-top: 60px;

}

</style>

コンポーネントのルーティング

src/router/index.js

import Vue from 'vue'

import Router from 'vue-router'

import HelloWorld from '@/components/HelloWorld'

Vue.use(Router)

export default new Router({

routes: [

{

path: '/',

name: 'HelloWorld',

component: HelloWorld

}

]

})

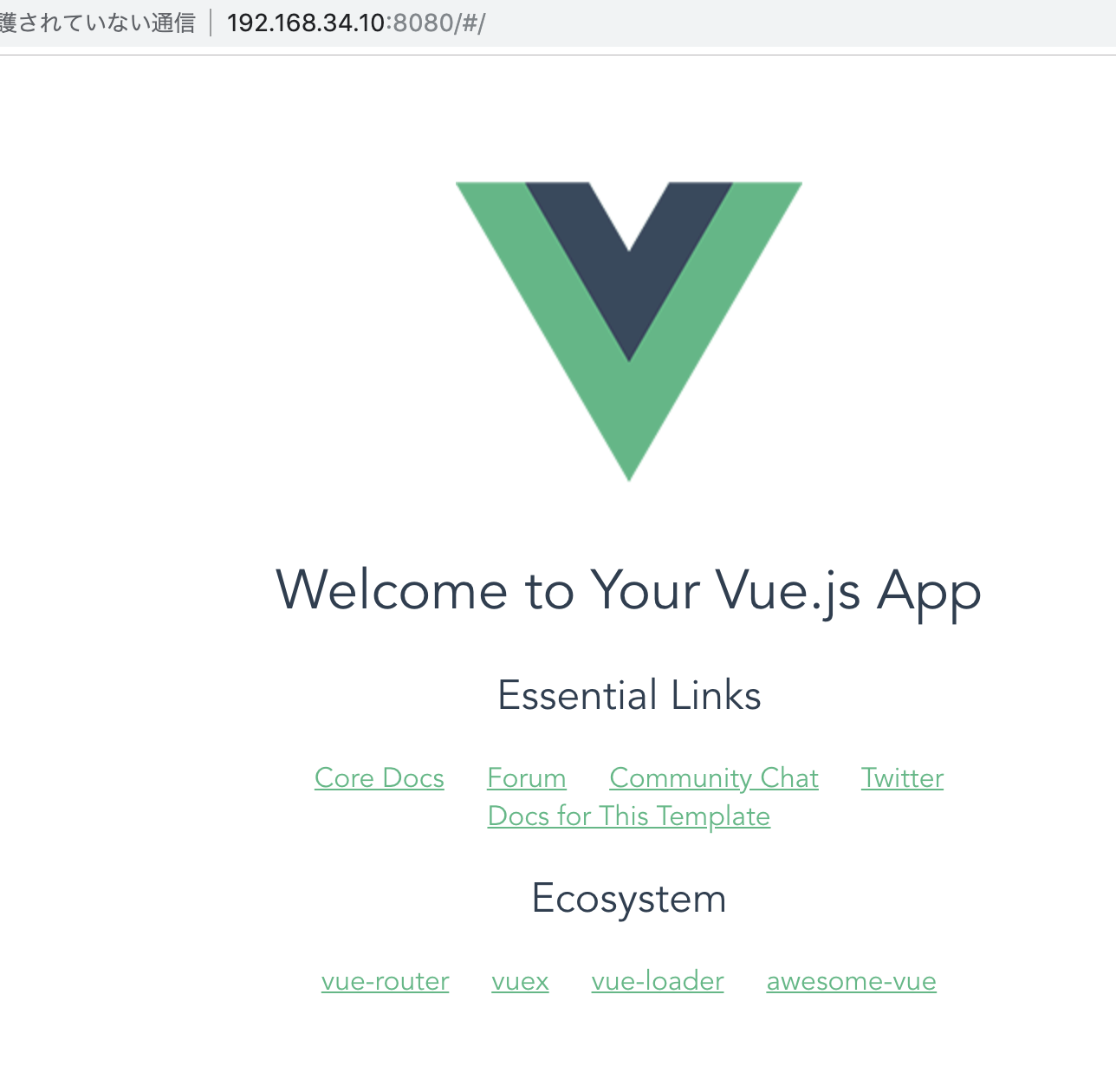

src/components/Hello.vue

<template>

<div class="hello">

<h1>{{ msg }}</h1>

<h2>Essential Links</h2>

<ul>

<li>

<a

href="https://vuejs.org"

target="_blank"

>

Core Docs

</a>

</li>

<li>

<a

href="https://forum.vuejs.org"

target="_blank"

>

Forum

</a>

</li>

<li>

<a

href="https://chat.vuejs.org"

target="_blank"

>

Community Chat

</a>

</li>

<li>

<a

href="https://twitter.com/vuejs"

target="_blank"

>

Twitter

</a>

</li>

<br>

<li>

<a

href="http://vuejs-templates.github.io/webpack/"

target="_blank"

>

Docs for This Template

</a>

</li>

</ul>

<h2>Ecosystem</h2>

<ul>

<li>

<a

href="http://router.vuejs.org/"

target="_blank"

>

vue-router

</a>

</li>

<li>

<a

href="http://vuex.vuejs.org/"

target="_blank"

>

vuex

</a>

</li>

<li>

<a

href="http://vue-loader.vuejs.org/"

target="_blank"

>

vue-loader

</a>

</li>

<li>

<a

href="https://github.com/vuejs/awesome-vue"

target="_blank"

>

awesome-vue

</a>

</li>

</ul>

</div>

</template>

<script>

export default {

name: 'HelloWorld',

data () {

return {

msg: 'Welcome to Your Vue.js App'

}

}

}

</script>

<!-- Add "scoped" attribute to limit CSS to this component only -->

<style scoped>

h1, h2 {

font-weight: normal;

}

ul {

list-style-type: none;

padding: 0;

}

li {

display: inline-block;

margin: 0 10px;

}

a {

color: #42b983;

}

</style>

気を取り直してkeep going