keras parameter

– input_dim: the size of the vocabulary

– output_dim: the size of the dense vector

– input_length: the length of the sequence

from keras.preprocessing.text import Tokenizer

from keras.preprocessing.sequence import pad_sequences

// 省略

tokenizer = Tokenizer(num_words=5000)

tokenizer.fit_on_texts(sentences_train)

X_train = tokenizer.texts_to_sequences(sentences_train)

X_test = tokenizer.texts_to_sequences(sentences_test)

vocab_size = len(tokenizer.word_index) + 1

embedding_dim = 50

maxlen = 100

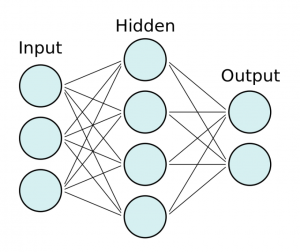

model = Sequential()

model.add(layers.Embedding(input_dim=vocab_size,

output_dim=embedding_dim,

input_length=maxlen))

model.add(layers.Flatten())

model.add(layers.Dense(10, activation='relu'))

model.add(layers.Dense(1, activation='sigmoid'))

model.compile(optimizer='adam',

loss='binary_crossentropy',

metrics=['accuracy'])

print(model.summary())

$ python3 test.py

_________________________________________________________________

Layer (type) Output Shape Param #

=================================================================

embedding (Embedding) (None, 100, 50) 87350

_________________________________________________________________

flatten (Flatten) (None, 5000) 0

_________________________________________________________________

dense (Dense) (None, 10) 50010

_________________________________________________________________

dense_1 (Dense) (None, 1) 11

=================================================================

Total params: 137,371

Trainable params: 137,371

Non-trainable params: 0

_________________________________________________________________

None

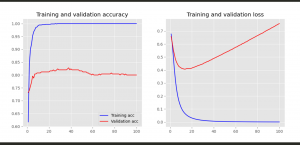

history = model.fit(X_train, y_train,

epochs=20,

verbose=False,

validation_data=(X_test, y_test),

batch_size=10)

loss, accuracy = model.evaluate(X_train, y_train, verbose=False)

print("Training Accuracy: {:.4f}".format(accuracy))

loss, accuracy = model.evaluate(X_test, y_test, verbose=False)

print("Testing Accuracy: {:.4f}".format(accuracy))

plot_history(history)

ValueError: Failed to find data adapter that can handle input: (

何でやろう。。。。

model = Sequential()

model.add(layers.Embedding(input_dim=vocab_size,

output_dim=embedding_dim,

input_length=maxlen))

model.add(layers.GlobalMaxPool1D())

model.add(layers.Dense(10, activation='relu'))

model.add(layers.Dense(1, activation='sigmoid'))

model.compile(optimizer='adam',

loss='binary_crossentropy',

metrics=['accuracy'])

_________________________________________________________________

Layer (type) Output Shape Param #

=================================================================

embedding (Embedding) (None, 100, 50) 87350

_________________________________________________________________

global_max_pooling1d (Global (None, 50) 0

_________________________________________________________________

dense (Dense) (None, 10) 510

_________________________________________________________________

dense_1 (Dense) (None, 1) 11

=================================================================

Total params: 87,871

Trainable params: 87,871

Non-trainable params: 0

_________________________________________________________________

なんかこんがらがってきた。。