import numpy as np import matplotlib.pyplot as plt %matplotlib inline x = np.arange(0,11) y = 4*x+3 plt.plot(x,y) plt.grid()

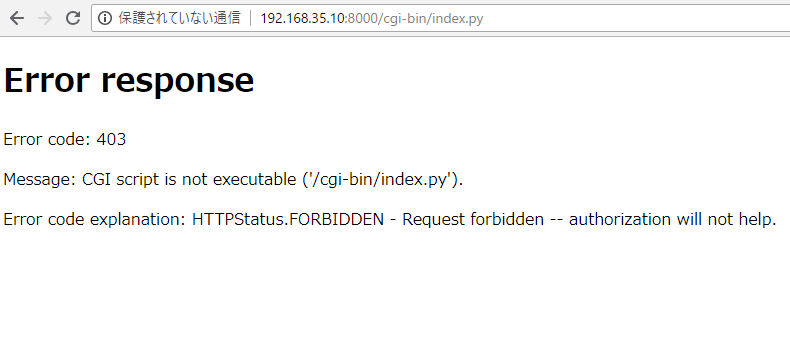

[vagrant@localhost python]$ python myapp.py

File “myapp.py”, line 3

%matplotlib inline

^

SyntaxError: invalid syntax

ん?これって、anacondaが入ってないって事?

[vagrant@localhost python]$ pyenv -v

pyenv 1.2.13

[vagrant@localhost python]$ pyenv install anaconda3-2019.03

Downloading Anaconda3-2019.03-Linux-x86_64.sh…

-> https://repo.continuum.io/archive/Anaconda3-2019.03-Linux-x86_64.sh

Installing Anaconda3-2019.03-Linux-x86_64…

Installed Anaconda3-2019.03-Linux-x86_64 to /home/vagrant/.pyenv/versions/anaconda3-2019.03

[vagrant@localhost python]$ python –version

Python 3.7.3

(anaconda3-2019.03)

(anaconda3-2019.03) [vagrant@localhost python]$ python myapp.py

File “myapp.py”, line 3

% matplotlib inline

^

SyntaxError: invalid syntax

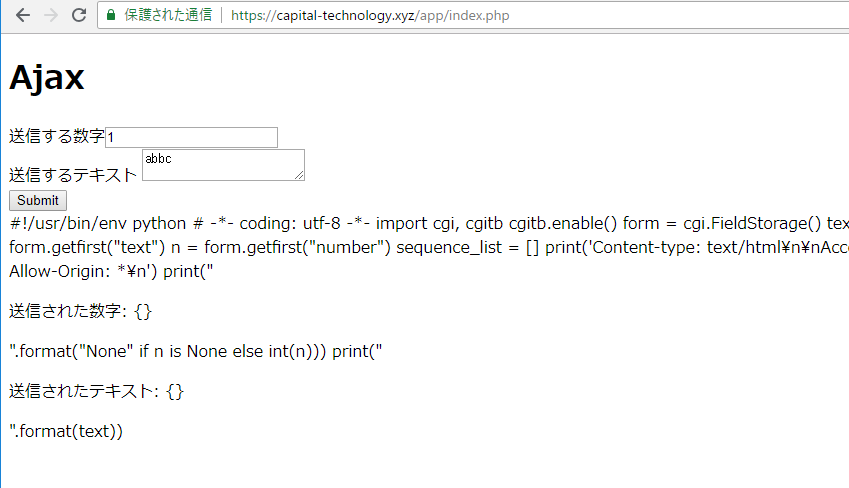

これはどうやらコマンドラインで画像を描画できないからっぽいですね。

まあよかった、原因がわかって。