## モーショングラフィックスとは

モーショングラフィックス(Motion Graphics)とは、文字・図形・写真・イラストなどの静止したデザイン要素に「動き」をつけて映像として表現する手法

例:

TV番組のオープニング

YouTubeのアニメーションロゴ

CMのテキスト演出

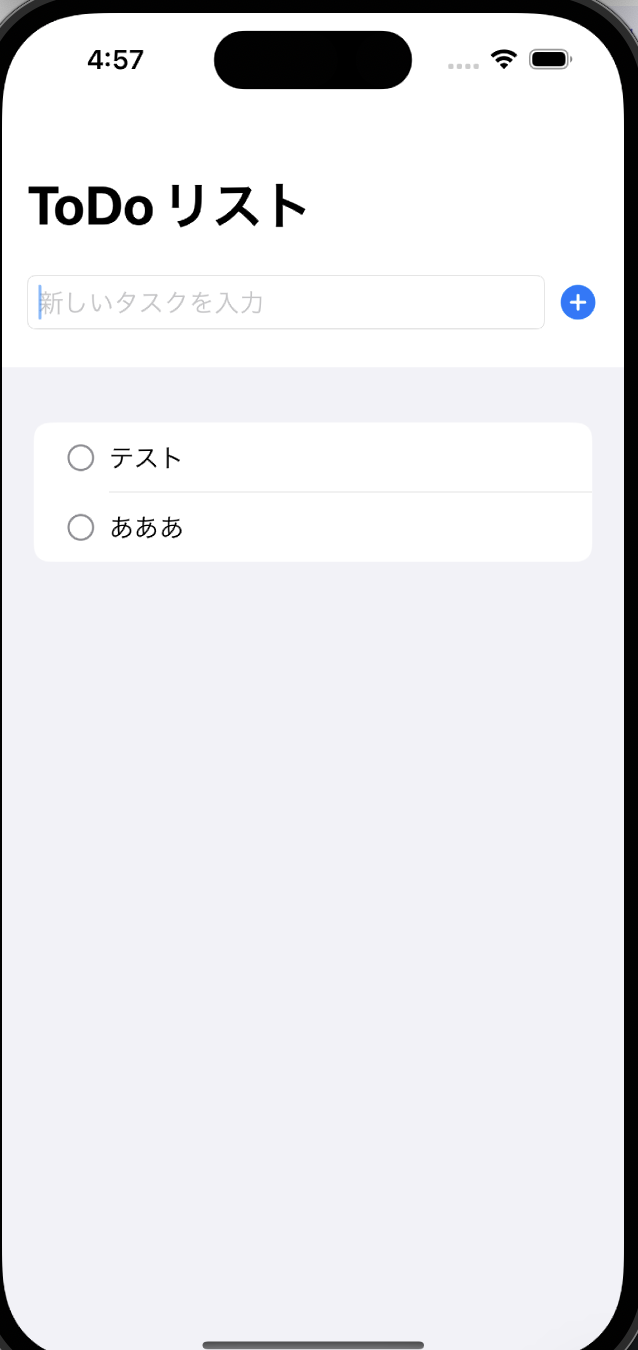

UI(アプリ画面など)の動きの紹介動画

モーショングラフィックスの基本要素

要素 説明

レイアウト 画面のどこに何を置くか

タイポグラフィ 字体・文字間・サイズ・配置の工夫

色(カラーリング) 視認性と印象を決める

トランジション 要素の出入りの動きのつなぎ方

イージング(Easing) 動きを自然に見せるための速度の緩急

リズム 音楽やテンポとの同期

特にモーショングラフィックスでは

「イージング(速度の変化)」が超重要です。

✨例:同じ移動でも…

一定速度 → 機械的で不自然

ゆっくり→速く→ゆっくり → 目に優しい・意味が伝わる

🎬 制作の流れ(基本のワークフロー)

企画・目的を決める

何を伝えたい?誰に向けて?

絵コンテ・デザインを作る

Illustrator などで静止画デザインを用意

アニメーションをつける

After Effects で動きをつける

音や効果を加える

BGM・効果音で印象アップ

書き出し

mp4 / mov / GIF など用途に応じて

よく使われるソフト

用途 ソフト名

動きをつける(メイン) Adobe After Effects

素材(イラスト・形状)作成 Adobe Illustrator / Photoshop

動画編集・音合わせ Adobe Premiere Pro / DaVinci Resolve

3D 表現(必要な場合) Blender / Cinema 4D

初心者がまず練習すべきこと

文字(テキスト)の出し方・消し方

図形が動く基本アニメーション

時間曲線(イージング)の調整

シンプルなロゴアニメーション制作

最初から複雑な作品は必要ありません。

小さな動きを美しく → これが上達の鍵です。